|

‘AI 반도체’는 크게 2가지 의미로 쓰입니다. 하나는 AI에 탑재되는 메모리반도체이고요, 또 다른 하나는 시스템반도체로, 둘 다 편의상 AI반도체라고 통칭하고 있습니다. 최근 주목받고 있는 반도체는 시스템반도체로 분류되는 그래픽처리장치(GPU)입니다.

AI에 쓰이는 반도체 중 최근 들어 GPU가 가장 많이 거론되고 있죠. 생성형 AI인 챗GPT에 엔비디아 GPU의 대표제품인 ‘A100’과 ‘H100’이 탑재되고 있어서입니다. 정확히 말하면 AI기능을 하는 반도체는 아닙니다. 엔비디아 GPU는 원래 중앙처리장치(CPU)를 보완해 고성능 게이밍에 이용됐지만, 성능이 뛰어나 AI 구동에 적극 활용되고 있습니다. CPU가 데이터를 순차적으로 처리하는 구조를 가졌다면 GPU는 여러 데이터를 동시에 처리하는 병렬 처리 능력이 뛰어나 대용량 데이터 처리에 강점을 갖습니다. 생성형 AI 구동을 위한 거대언어모델(LLM)을 개발하려면 CPU를 도울 GPU가 필요하며 엔비디아 GPU가 최적화돼 있는 것이죠. 챗GPT는 AI 추론 작업에 필요한 엔비디아 GPU를 대량으로 소모합니다. 딜런 파텔 세미애널리시스 수석분석가에 따르면 오픈AI는 2만8936장의 A100로 이뤄진 컴퓨터 클러스터를 보유하고 있습니다.

|

또 다른 팹리스인 AMD도 GPU를 공급하며 엔비디아에 도전장을 내민 상황으로, 지난달 ‘MI300X’ 출시를 예고했습니다. 이 제품은 최대 192GB의 메모리를 탑재해 큰 AI 모델에 장착할 수 있다고 설명했는데, 엔비디아 H100의 120GB를 능가하는 것입니다. 현재 엔비디아 H100의 경우 개당 가격이 3만달러가 넘는데 AMD 제품은 이것보다 비싸지 않을 것으로 보입니다. 따라서 가격 경쟁력이 충분할 것이라는 게 업계 관측입니다.

‘차세대 D램’ HBM…삼성·SK 경쟁 구도

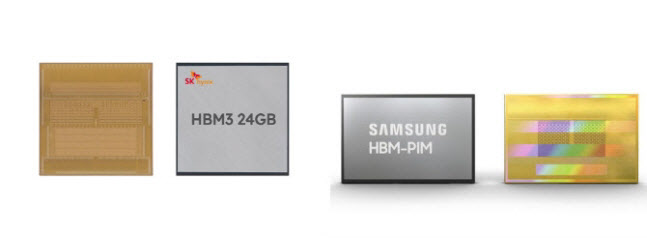

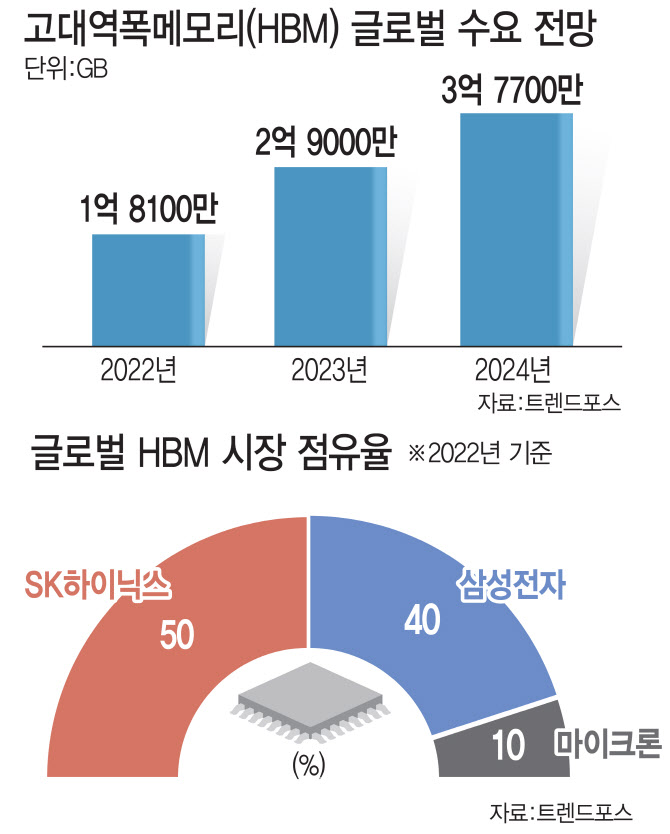

AI에 필요한 반도체로 HBM(고대역폭메모리)을 빼놓을 수 없습니다. AI 서비스를 위한 데이터센터에는 GPU 뿐만 아니라 HBM이라는 메모리반도체가 탑재됩니다. HBM은 D램 여러 개를 수직으로 쌓은 뒤 1024개의 정보 출입구를 뚫어 연결한 제품으로, 기존 D램보다 데이터 처리 속도를 대폭 끌어올렸습니다. 기존 제품 가격의 5~6배에 상당해 이를 개발·양산하는 삼성전자와 SK하이닉스의 고부가 제품으로도 꼽힙니다. 결국 생성형 AI가 확대될수록 GPU뿐 아니라 HBM 시장도 같이 커진다고 볼 수 있죠. 트렌드포스에 따르면 올해 전 세계 HBM 수요는 2억9000만 기가바이트(GB)로 전년 대비 60%가량 증가할 전망입니다. 내년 HBM 수요는 30% 추가 성장할 것으로 전망되고 있습니다. 또 향후 HBM은 고성능 데이터센터에 탑재되며 AI의 완성도를 높이는 머신러닝과 기후변화 해석, 신약개발 등에 사용되는 슈퍼컴퓨터에도 적용될 전망입니다.

엔비디아 GPU 제품에는 HBM3를 공급하는 SK하이닉스가 주목을 받는 이유이기도 합니다. HBM3는 HBM 4세대 제품으로, 초당 데이터 처리 속도가 819GB(기가바이트)에 달해 초고속 AI 반도체 시장에서 최적의 제품으로 평가받고 있습니다. 현재로선 전 세계 HBM시장에서 SK하이닉스가 가장 큰 시장점유율을 차지하고 있습니다. 트렌드포스는 지난해 SK하이닉스·삼성전자·마이크론 등 3개사의 시장점유율을 각각 50%, 40%, 10% 수준으로 집계했습니다.

|

삼성전자의 HBM-PIM은 GPU 업계 2위 기업인 AMD의 GPU(MI-100) 가속기 카드에 탑재됐습니다. 성능이 탑재 전과 비교해 2배 늘고 에너지 소모는 50% 줄어들었다고 합니다.

이뿐 아니라 삼성전자와 SK하이닉스는 HBM3보다 성능이 강화된 신제품 개발·양산 계획을 깜짝 발표했습니다. SK하이닉스는 올해 하반기 8기가비피에스(Gbps) HBM3E 제품 샘플을 준비하겠다며 내년 상반기 양산을 예고했습니다. 삼성전자는 이에 맞서 HBM3P 개발 과정을 공개했습니다. 삼성전자는 플러스(Plus)의 P를, SK하이닉스는 익스텐디드(Extended)의 E를 제품명인 HBM3 뒤에 붙였는데, 제품 성능 경쟁도 향후 관전포인트가 될 것 같습니다.

|

![산업 커지는 폴더블폰…후발업체들 “타도 삼성” 공세 [미래기술25]](https://image.edaily.co.kr/images/Photo/files/NP/S/2023/09/PS23092000033t.jpg)