|

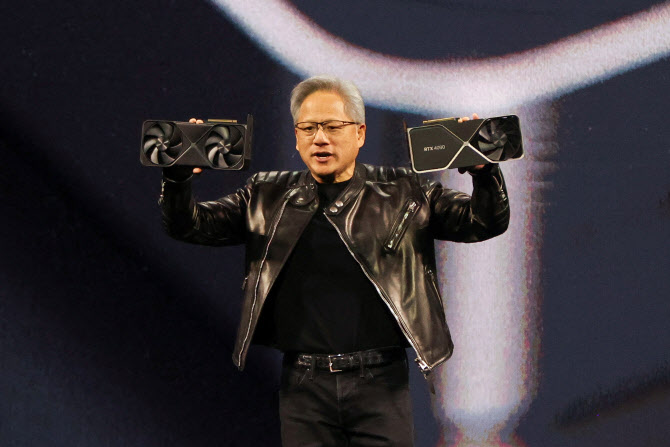

18일(현지시간) 평소처럼 검은 가죽 자켓과 청바지를 입고 기조연설 무대에 선 황 CEO는 “거의 전 세계가 잘못 생각하고 있다”고 말했다. 그는 “지난 2~3년 사이에 AI에 근본적 발전이 있었는데 우리는 에이전트 AI라고 부른다”며 “즉 자율적으로 작업을 수행하는 AI가 등장하면서 필요한 연산량은 작년 이맘때 예상했던 것보다 100배는 많아졌다”고 말했다.

최근 AI개발 흐름이 ‘훈련’(training)에서 ‘추론’(inferemce)으로 변화하면서 엔비디아의 주력 제품인 고가의 AI칩은 압박을 받고 있다. 엔비디아 매출은 2022년 후반 오픈AI의 챗GPT 출시로 사업이 전환된 이후 6배 이상 증가했다. 그것은 엔비디아의 GPU가 첨단AI를 개발하는 과정인 훈련 시장에서 필수적인 것으로 여겨졌기 때문이다. 엔비디아의 GPU를 얼마나 구축해 컴퓨팅 파워를 얼마나 끌어올리느냐가 AI의 성능을 좌우하는 요소로 여겨졌고, 이에 따라 마이크로소프트(MS), 구글, 아마존 등 대형 클라우드 업체들을 중심으로 막대한 투자가 이어졌다.

그러나 최근 중국의 AI모델 딥시크가 기존보다 적은 AI칩과 낮은 성능의 AI로 고성능 AI 구축에 성공하면서 엔비디아의 고성능, 고가 반도체가 이전처럼 막대하게 필요한가라는 의문이 제기됐다.

|

황 CEO는 이번 행사에서 차세대 GPU칩인 ‘블랙웰 울트라’를 공개하며 엔비디아야말로 이같은 변화를 가장 잘 지원하는 반도체라고 홍보했다. 그는 엔비디아의 AI칩이 두 가지 핵심 역할을 한다고 강조했다. 첫째, AI 시스템이 다수의 사용자에게 스마트한 답변을 제공하는 것, 두 번째 이 답변을 가능한 한 빠르게 제공하는 것이다.

황 CEO는 “질문에 답변하는 데 너무 오래 걸리면, 고객이 다시 찾아오지 않을 것”이라며 “이는 웹검색과도 같다”고 강조했다. 그는 블랙웰 울트라가 초당 더 많은 토큰을 생성할 수 있어 기존 칩보다 동일시간 더 많은 콘텐츠를 생성할 수 있다고 밝혔다.

엔비디아에 따르면 이는 클라우드 제공업체가 블랙웰 울트라를 활용해 시간에 민감한 애플리케이션을 위한 프리미엄 AI 서비스를 제공할 수 있으며, 이를 통해 2023년에 출시된 호퍼(Hopper) 세대 칩보다 최대 50배의 수익을 창출할 수 있다고 설명했다.

블랙웰 울트라는 엔비디아의 Arm 기반 CPU와 페어링된 GB300 버전, 그리고 GPU만 포함된 B300 버전으로 출시된다. 또한, 단일 서버 블레이드에 8개의 GPU가 포함된 버전과, 72개의 블랙웰 칩이 장착된 랙(rack) 버전도 제공될 예정이다.

엔비디아는 상위 4개 클라우드 기업이 호퍼 칩보다 블랙웰 칩을 3배 더 많이 배치했다고 밝혔다. 블랙웰 울트라는 올해 하반기 출시될 예정이다.

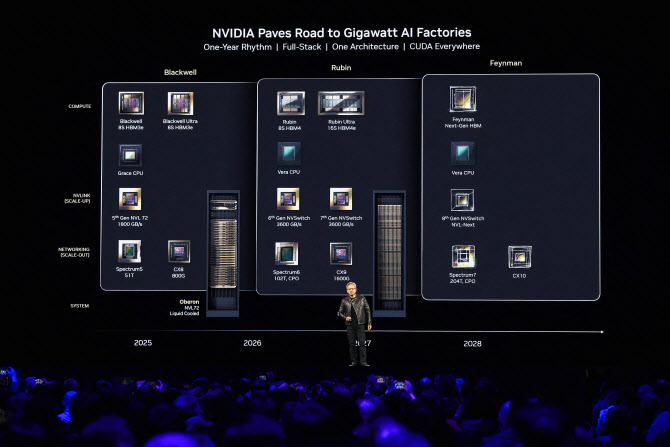

2026년 하반기 베라 루빈…엔비디아 최초 자체 CPU 탑재

블랙웰을 계승할 베라 루빈의 세부 사항도 공개됐다. 이 칩은 더 빠른 속도를 제공하며 2026년 하반기 출시될 예정이다. 우주 암흑물질을 발견한 여성 천문학자의 이름을 딴 이 제품은 CPU인 ‘베라’와 새로운 GPU디자인인 ‘루빈’으로 이뤄진다. 엔비디아는 베라가 자사의 최초 맞춤형 CPU 설계라고 설명하며 이는 올림푸스라는 자체 개발 코어 디자인을 기반으로 만들었다고 밝혔다. 이전까지 엔비디아는 암(Arm)의 범용 설계를 사용해 CPU를 만들어왔다. 엔비디아는 맞춤형 베라 CPU가 작년 출시된 그레이스 블랙웰의 CPU보다 2배 빠르다고 강조했다.

베라와 함꼐 사용될 루빈 GPU는 추론 작업에서 50페타플롭스(PFLOPS)를 처리할 수 있으며 이는 현재 블랙웰이 제공하는 20페타플롭스보다 2배 이상 높은 성능이다. 또 최대 288GB의 초고속 메모리를 지원한다.

2027년 하반기에는 루빈보다 성능이 2배 빠른 ‘루빈 넥스트’가 나온다. 엔비디아는 지금까지는 두 개의 개별칩을 결합해 하나의 칩을 작동할 경우, 이를 하나의 GPU로 봤지만 루빈 부터는 각각 개별 GPU로 간주하겠다고 발표했다. 이에 따라 루빈 넥스트는 게 개의 다이(die, 칩 내부 연산코어)를 결합한 설계로 ‘네 개의 GPU’로 간주한다고 밝혔다.

엔비이아는 이 칩이 ‘베라 루빈 NVL144’라는 랙 시스템에서 제공될 예정이라고 밝혔다. 기존 엔비디아 렉 제품은 NVL72이라는 이름을 사용했다.

2028년 파인만…다음세대 HBM 적용

루빈 다음에는 2028년 신형 설계를 적용한 파인만 칩이 개발된다. 물리학자 리처드 파인만의 이름을 따서 명명했다. 이날 황 CEO는 파인만에 대해 코드명만을 소개했을 뿐 구체적인 사항을 공개하지는 않았으나 HBM4E의 다음 세대 HBM이 적용되고 칩셋 내부 대역폭 또한 초당 3600GB가 목표인 루빈을 뛰어넘는다고 한다.

!["엄마, 그놈이 곧 나온대"...끝내 숨진 여고생이 남긴 말 [그해 오늘]](https://image.edaily.co.kr/images/vision/files/NP/S/2026/02/PS26021600001t.jpg)