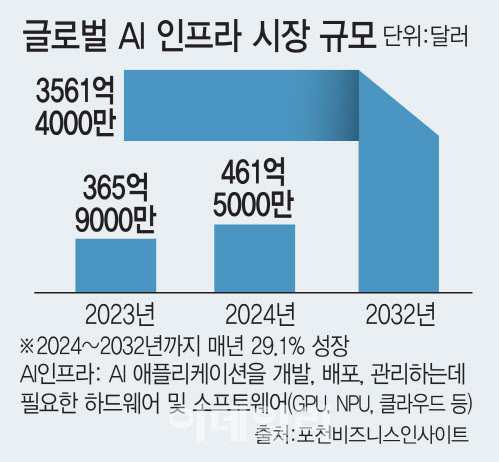

포춘 비즈니스 인사이트에 따르면, 전 세계 AI 인프라 시장은 올해 461억 5000만 달러(약 61.5조원)에서 2032년에는 3561억 4000만 달러(약 497.8조원)로 매년 29.1%씩 성장할 전망이다. 전 세계 AI 프로세서 시장의 80% 이상을 차지하는 엔비디아. 한국에서도 엔비디아의 틈새를 노리는 혁신 기업들이 치열하게 뛰고 있다.

|

27일 업계에 따르면 SK하이닉스(000660)·삼성전자(005930) 등 국내 반도체 기업들은 고성능 AI칩을 위한 고대역폭메모리(HBM)로, 리벨리온·퓨리오사AI·네이버와 인텔 등은 데이터센터용 AI칩 시장에서 추론용(서비스용)칩 개발에 한창이다.

딥엑스는 애플이나 화웨이, 퀄컴의 온디바이스용 AI칩에 맞서기 위해 CCTV 등 사물인터넷단말기(IoT) 탑재 AI칩부터 상용화를 추진 중이고, 파두는 AI데이터센터를 겨냥해 총소유비용(TCO)을 낮출 수 있는 전력관리반도체(PMIC)와 컴퓨트익스프레스링크(CXL)스위치를, 모레는 세계적인 반도체 프로세서 전문가 짐 켈러(Jim Keller)가 이끄는 AI 반도체 기업 텐스토렌트(Tenstorrent)와 함께 AI데이터센터 솔루션 시장에 뛰어들었다.

메모리와 파운드리 강국인 대한민국이 엔비디아 GPU에 들어가는 HBM(고대역폭 메모리)을 주도하는 것은 어찌 보면 자연스러운 일이다. 오픈AI, 구글, 메타와 같은 글로벌 빅테크 기업들이 거대언어모델(LLM)을 개발하려면 고성능 GPU가 필요한데, 이를 구동하는 것이 HBM이다.

그러나 10년, 20년 후에도 엔비디아 칩이 대세일지는 장담하기 어렵다. 너무 비싸기 때문이다.

파두(440110)의 실리콘밸리 자회사 이음(EEUM)의 한진기 대표는 “금융, 통신, 교육 등 분야별 특화된 AI 서비스는 소형 언어 모델(sLLM)로도 충분히 가능하다”며, “이 시장이 커지면 엔비디아 GPU가 구동하는 HBM보다 단일 장치에 여러 모델을 담을 수 있는 기술인 CXL 시대가 열릴 것”이라고 전망했다.

네이버, 인텔 공동 칩으로 AI 비용 절감 기대…선택과 집중

리벨리온, 퓨리오사AI, 네이버(NAVER(035420)), 인텔 등은 데이터센터에서 사용되는 추론용 AI 칩을 개발하고 있다. 네이버는 인텔과 협력해 개발한 ‘가우디’ 칩을 엔비디아 칩(A100과 H100) 대신 자사 데이터센터에 도입하면 비용을 크게 줄일 것으로 기대하고 있다.

리벨리온은 델, HPE, 슈퍼마이크로 등 서버업체들로부터 AI 반도체 ‘아톰’의 성능 인증을 마쳤고, 사우디아라비아 아람코 데이터센터에서 자격 검증(PoC)을 진행 중이다. 대만 반도체 모듈 기업 페가트론과 차세대 모델인 ‘리벨’을 탑재한 고성능 모듈 제품 개발에 착수했고, 엔비디아 GPU의 독점 기반인 쿠다(CUDA)에 맞설 오픈소스 머신러닝 라이브러리인 ‘파이토치 파운데이션’에도 국내 기업 최초로 참여했다.

박성현 리벨리온 대표는 “인공지능 훈련 영역에서는 엔비디아의 지위가 굳건하지만, 추론에 특화된 AI반도체 영역에서는 대한민국도 도전해 볼 만하다”라며, “HBM 경쟁력도 있고, 국가적으로 AI 데이터센터에 큰 지원과 관심이 있는만큼 선택과 집중을 통해서 AI 반도체에서 승부를 볼 수 있다”라고 말했다.

|

!['36.8억' 박재범이 부모님과 사는 강남 아파트는[누구집]](https://image.edaily.co.kr/images/vision/files/NP/S/2026/02/PS26021500062t.jpg)